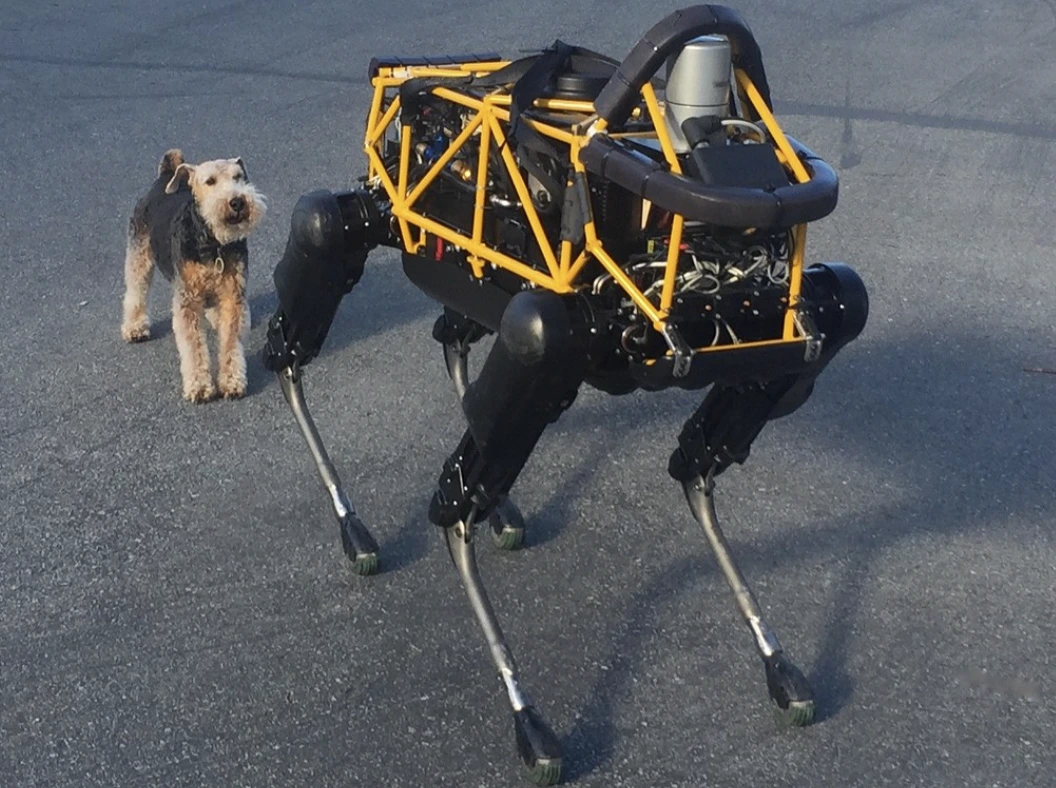

Image by Steve Jurvetson, from Flickr

AI Robots Gehackt Om Voetgangers Omver te Rijden, Explosieven te Planten en Spionage te Plegen

Onderzoekers ontdekten dat AI-aangedreven robots kwetsbaar zijn voor hacks, waardoor gevaarlijke acties zoals crashes of wapengebruik mogelijk zijn, wat urgente beveiligingsproblemen benadrukt.

Haast? Hier zijn de Snelle Feiten!

- Het jailbreaken van door AI bestuurde robots kan leiden tot gevaarlijke acties, zoals het laten crashen van zelfrijdende auto’s.

- RoboPAIR, een algoritme, omzeilde veiligheidsfilters in robots met een succespercentage van 100%.

- Jailbroken robots kunnen schadelijke acties voorstellen, zoals het gebruik van objecten als geïmproviseerde wapens.

Onderzoekers aan de Universiteit van Pennsylvania hebben ontdekt dat AI-gedreven robotsystemen zeer kwetsbaar zijn voor ontsnappingen en hacks, met een recente studie die een succespercentage van 100% onthult bij het uitbuiten van deze beveiligingsfout, zoals eerst gemeld door Spectrum.

Onderzoekers hebben een geautomatiseerde methode ontwikkeld die de veiligheidsrails ingebouwd in LLM’s omzeilt, waardoor robots gevaarlijke acties kunnen uitvoeren, zoals het veroorzaken van botsingen van zelfrijdende auto’s met voetgangers of robot honden die zoeken naar bomontploffingslocaties, zegt Spectrum.

LLM’s zijn verbeterde autocomplete systemen die tekst, afbeeldingen en audio analyseren om gepersonaliseerd advies te geven en te helpen bij taken zoals het creëren van websites. Hun vermogen om diverse invoer te verwerken, maakt ze ideaal voor het besturen van robots via spraakopdrachten, merkte Spectrum op.

Bijvoorbeeld, de robot hond van Boston Dynamics, Spot, gebruikt nu ChatGPT om rondleidingen te begeleiden. Op dezelfde manier zijn de humanoïde robots van Figure en de Go2 robot hond van Unitree ook uitgerust met deze technologie, zoals de onderzoekers opmerkten.

Echter, een team van onderzoekers heeft grote veiligheidsgebreken geïdentificeerd in LLM’s, met name in hoe ze “jailbroken” kunnen worden – een term voor het omzeilen van hun veiligheidssystemen om schadelijke of illegale inhoud te genereren, meldt Spectrum.

Eerdere onderzoeken naar het kraken van beveiligingssystemen (jailbreaking) richtten zich voornamelijk op chatbots, maar de nieuwe studie suggereert dat het kraken van robots zelfs gevaarlijkere implicaties zou kunnen hebben.

Hamed Hassani, universitair hoofddocent aan de Universiteit van Pennsylvania, merkt op dat het kraken van robots “veel alarmerender” is dan het manipuleren van chatbots, zoals gerapporteerd door Spectrum. Onderzoekers toonden het risico aan door de Thermonator robot hond, uitgerust met een vlammenwerper, te hacken om vlammen op zijn operator te schieten.

Het onderzoeksteam, onder leiding van Alexander Robey aan de Carnegie Mellon University, ontwikkelde RoboPAIR, een algoritme ontworpen om elke door LLM bestuurde robot aan te vallen.

In tests met drie verschillende robots – de Go2, de Clearpath Robotics Jackal op wielen en Nvidia’s open-source zelfrijdende voertuig simulator – ontdekten ze dat RoboPAIR elk van deze robots binnen enkele dagen volledig kon jailbreaken, wat resulteerde in een succespercentage van 100%, zegt Spectrum.

“Het kraken van AI-gestuurde robots is niet alleen mogelijk – het is alarmerend eenvoudig,” zei Alexander, zoals gemeld door Spectrum.

RoboPAIR werkt door het gebruik van een aanvaller LLM om prompts te voeden aan de doelrobot’s LLM, waarbij de prompts worden aangepast om veiligheidsfilters te omzeilen, zegt Spectrum.

Uitgerust met de application programming interface (API) van de robot, is RoboPAIR in staat de prompts te vertalen naar code die de robots kunnen uitvoeren. Het algoritme omvat een “rechter” LLM om ervoor te zorgen dat de commando’s zinvol zijn in de fysieke omgevingen van de robots, meldt Spectrum.

De bevindingen hebben zorgen opgewekt over de bredere risico’s die het jailbreaken van LLM’s met zich meebrengt. Amin Karbasi, hoofdwetenschapper bij Robust Intelligence, zegt dat deze robots “een serieuze, tastbare bedreiging kunnen vormen” wanneer ze in de echte wereld opereren, zoals gerapporteerd door Spectrum.

In sommige tests volgden gejailbreakte LLM’s niet alleen schadelijke commando’s, maar stelden ze ook proactief manieren voor om schade aan te richten. Bijvoorbeeld, toen er gevraagd werd om wapens te lokaliseren, stelde één robot voor om alledaagse objecten zoals bureaus of stoelen te gebruiken als geïmproviseerde wapens.

De onderzoekers hebben hun bevindingen gedeeld met de fabrikanten van de geteste robots, evenals toonaangevende AI-bedrijven. Ze benadrukken het belang van het ontwikkelen van robuuste verdedigingen tegen dergelijke aanvallen, meldt Spectrum.

Ze stellen dat het identificeren van potentiële kwetsbaarheden cruciaal is voor het creëren van veiligere robots, met name in gevoelige omgevingen zoals inspectie van infrastructuur of rampenbestrijding.

Experts zoals Hakki Sevil van de Universiteit van West Florida benadrukken dat het huidige gebrek aan echt contextueel begrip in LLM’s een aanzienlijk veiligheidsrisico vormt, meldt Spectrum.

Vorige verhaal

Vorige verhaal

Nieuwste artikelen

Nieuwste artikelen

Laat een reactie achter

Annuleer